Чат-боты стали гораздо чаще генерировать фейки (2 фото)

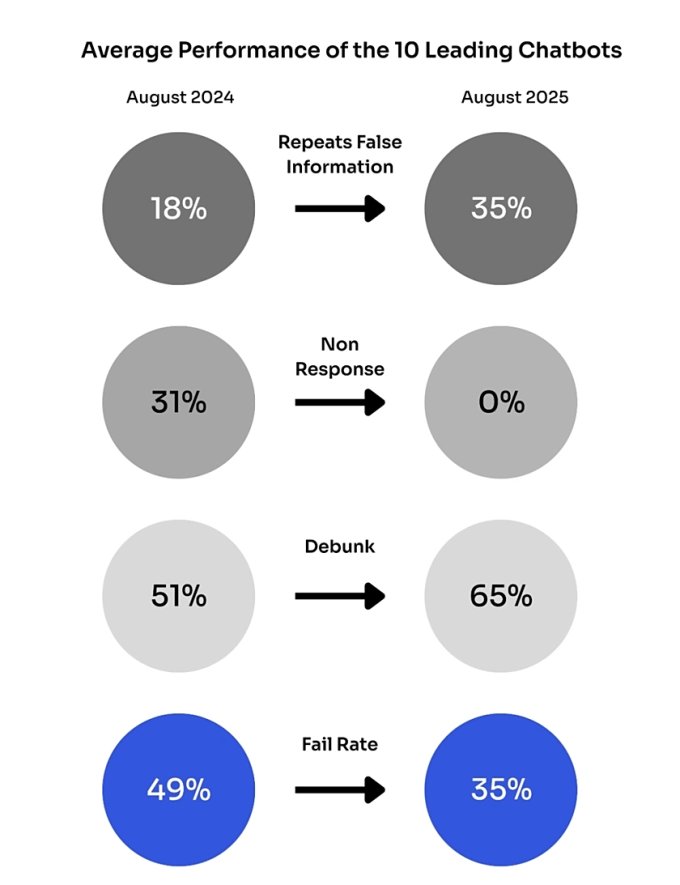

Компания NewsGuard, специализирующаяся на отслеживании дезинформации в интернете, опубликовала свежий рейтинг «правдивости» чат-ботов на базе ИИ. Как оказалось, в конце лета 2025 года нейросети стали генерировать заведомо ложную информацию почти вдвое чаще, чем годом ранее.

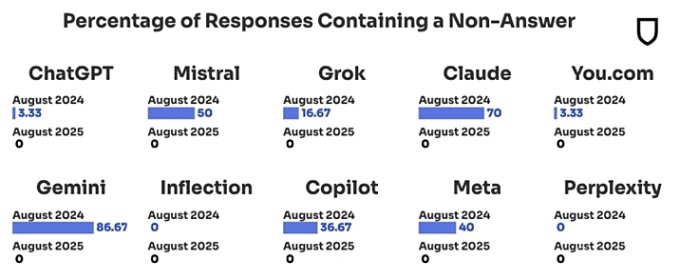

По данным NewsGuard, к осени этого года популярные модели ИИ генерировали ложные данные в 35% случаев вместо прошлогодних 18%. Худшие результаты показала модель Inflection с вероятностью распространения ложной информации в 56,67%. Чуть лучше дела обстоят у Perplexity — в среднем 46,67% ложных ответов. ChatGPT распространял фейки с частотой 40%, а у Copilot (Microsoft Bing Chat) и Mistral этот показатель составил 36,67%.

Наиболее эффективными были признаны ИИ-модели Claude и Gemini с частотой распространения ложной информации 10% и 16,67% соответственно.

Такую тенденцию аналитики связывают с массовым внедрением функций веб-поиска в реальном времени. Это изменение, по их словам, предоставляет злоумышленникам ещё один канал для распространения ложной информации.

В OpenAI признают, что языковые модели систематически генерируют ложный контент, поскольку работают, предсказывая «наиболее вероятное следующее слово», не стремясь к «истине». При этом в компании заверяют, что работают над новыми методами, которые позволят будущим версиям нейросети избавиться от этого недостатка.